ChatGPT wurde vor einem Jahr und einigen Monaten der Öffentlichkeit vorgestellt. Seitdem gibt es in vielen Bereichen einen zunehmenden Trend, es einzusetzen, um einige der Aufgaben von Menschen zu ersetzen oder eine neue Möglichkeit zu bieten, Menschen bei der Suche nach Antworten auf ihre Fragen zu helfen.

Die Welt der Webbrowser bleibt von diesem Trend nicht verschont, denn es gibt zahlreiche Beispiele für Webbrowser, die auf die eine oder andere Weise LLM-Funktionen (Large Language Model) integrieren.

Doch obwohl sie dies im Namen der Zukunft tun, scheint keiner von ihnen die offensichtlichen Mängel dieser Funktionen zu berücksichtigen: Die LLMs selbst sind einfach nicht als Gesprächspartner oder Zusammenfassungsmaschinen geeignet und können nur bei der Generierung von Sprache helfen, wobei ein erhebliches Plagiatsrisiko besteht.

Um zu verstehen, warum all dies grundlegende Probleme sind und keine Probleme, die irgendwann gelöst werden können, sollten wir uns mit der Natur von LLMs befassen.

Wir möchten hier nicht in eine sehr langatmige Erklärung der Feinheiten von LLMs einsteigen. Stattdessen begnügen wir uns mit einer kürzeren Erklärung. Dabei bleiben vielleicht einige Vorbehalte unberücksichtigt, aber alles, was hier gesagt wird, trifft auf die großen, beliebten generischen LLMs zu.

Viele Experten auf diesem Gebiet haben dies bereits hervorragend erklärt. Hier ist ein interessanter Artikel: „Du bist kein Papagei. Und ein Chatbot ist kein Mensch“.

Was sind LLMs?

LLMs sind lediglich ein Modell dafür, wie eine geschriebene Sprache aussieht. Es handelt sich um eine mathematische Beschreibung ihres Aussehens. Es wird durch die Untersuchung einer Vielzahl von Quellen erstellt und konzentriert sich darauf, zu beschreiben, welches Wort am wahrscheinlichsten auf eine große Menge anderer Wörter folgt. Das System wird mit einem gewissen Maß an Zufälligkeit versehen, um es interessanter zu gestalten, und die Ausgabe wird dann durch ein zweites Modell gefiltert, das bestimmt, wie „gut“ diese Ausgabe klingt. In mehreren Fällen wurde dieses Modell der zweiten Stufe erstellt, indem viele (unterbezahlte) Menschen sich die Ergebnisse der ersten Stufe ansahen und entschieden, ob sie ihnen gefielen oder nicht und ob sie plausibel klangen.

Dies wirft zwei grundlegende Probleme auf:

- Verstöße gegen das Urheberrecht und den Datenschutz

Um eine gute Vorstellung davon zu bekommen, welches Wort wahrscheinlich auf eine Reihe von Wörtern folgt, muss man sich eine Menge Text ansehen. Je mehr Text, desto besser, da jedes Stück Text es ermöglicht, das Modell so anzupassen, dass es eine genauere Darstellung einer Sprache liefert. Außerdem muss ein Großteil des eingespeisten Textes relativ aktuell sein, um den aktuellen Sprachgebrauch widerzuspiegeln. Das bedeutet, dass ein enormer Anreiz besteht, Text aus allen verfügbaren aktuellen Quellen zu konsumieren, von sozialen Medien bis hin zu Artikeln und Büchern. Leider bedeutet die Einbindung solcher Texte in das Modell, dass es möglich ist, dass es denselben Text wortwörtlich ausgibt. Dies geschieht, wenn es für eine bestimmte Eingabesequenz keine bessere Wahl gibt, als diesen Originaltext wiederzugeben. Infolgedessen wiederholen diese Modelle in einigen Fällen einfach urheberrechtlich geschütztes Material, was zu Plagiaten führt. Ebenso kann die Masse an Texten aus sozialen Medien und anderen von Nutzern bereitgestellten Quellen sensible, private Informationen enthalten, die ebenfalls wiedergegeben werden können. Einige clevere Leute haben Wege gefunden, dieses Verhalten auszulösen, und es ist unwahrscheinlich, dass man sich vollständig davor schützen kann. Da wir uns der Gefahr bewusst sind, die durch die Offenlegung privater Informationen entsteht, waren wir nie begeistert von der Idee, dass diese möglicherweise in diese Modelle eingebaut werden könnten. - Plausibel klingende Lügen

Da der Text, aus dem ein LLM aufgebaut ist, zum großen Teil aus dem Internet stammt, bedeutet dies, dass ein Großteil davon völliger Müll ist. Das reicht von schlecht geschriebener Prosa über sachliche Fehler bis hin zu tatsächlich beleidigenden Inhalten. Frühe Experimente mit dieser Technologie führten zu Chatbots, die schnell selbst beleidigende Sprache von sich gaben und damit bewiesen, dass sie für ihren Zweck ungeeignet sind. Aus diesem Grund werden moderne LLMs durch eine zweite Stufe moderiert, die ihre Ausgabe filtert. Leider wird diese zweite Stufe, wie oben beschrieben, von Menschen aufgebaut, die die Ausgabe der ersten Stufe bewerten. Damit dies sinnvoll ist, müssen sie riesige Mengen an Ausgaben prüfen. Selbst die sachkundigsten Menschen der Welt könnten nicht hoffen, alles auf seine Richtigkeit zu überprüfen, und selbst wenn sie es könnten, könnten sie nicht alle Ergebnisse kennen, die jemals produziert werden. Für diese hilft der Filter lediglich dabei, den Ton anzugeben. All dies führt dazu, dass die Art von Ergebnissen bevorzugt wird, die die Menschen gerne sehen, nämlich selbstbewusst klingende Texte, unabhängig von ihrer Richtigkeit. Bei allgemein bekannten Fakten liegen sie meist richtig, aber bei allem anderen ist es ein Glücksspiel. In den meisten Fällen liefern sie einfach eine Lüge auf Politiker-Niveau.

Das Richtige tun

Wie wir gesehen haben, sind LLMs im Wesentlichen selbstbewusst klingende Lügenmaschinen mit einer Vorliebe dafür, gelegentlich private Daten preiszugeben oder bestehende Werke zu plagiieren. Dabei verbrauchen sie enorme Mengen an Energie und nutzen gerne alle GPUs, die man ihnen zur Verfügung stellt, was ein Problem ist, das wir bereits im Bereich der Kryptowährungen gesehen haben.

Daher erscheint es uns nicht richtig, eine solche Lösung in Vivaldi zu integrieren. Es gibt bereits genug Fehlinformationen, als dass wir riskieren möchten, noch mehr hinzuzufügen. Wir werden kein LLM verwenden, um einen Chatbot, eine Zusammenfassungslösung oder eine Vorschlagsmaschine zum Ausfüllen von Formularen hinzuzufügen, bis strengere Methoden für diese Aufgaben verfügbar sind.

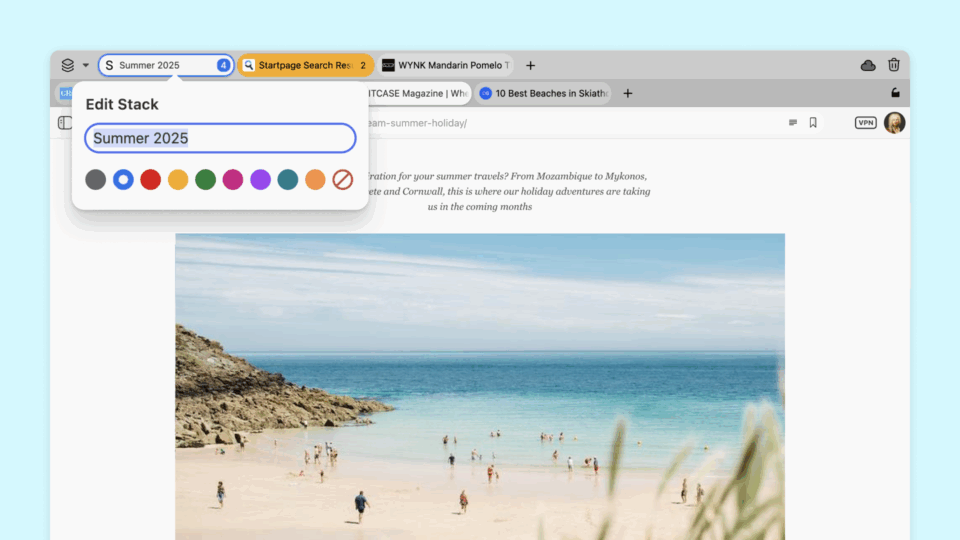

Dennoch geht es bei Vivaldi um Wahlmöglichkeiten, und wir werden es den Nutzern weiterhin ermöglichen, jedes LLM zu verwenden, das sie online wünschen.

Trotz alledem sind wir der Meinung, dass der Bereich des maschinellen Lernens im Allgemeinen weiterhin spannend ist und zu Funktionen führen kann, die tatsächlich nützlich sind. Wir hoffen, dass wir unseren Nutzern in Zukunft damit gute Funktionen zum Schutz der Privatsphäre bieten können, wobei der Schwerpunkt auf der Verbesserung der Auffindbarkeit und Zugänglichkeit liegt.

Wir werden uns weiterhin bemühen, ein funktionsreiches und ethisches Surferlebnis zu bieten.